Το σύστημα CSAM, για τον εντοπισμό περιστατικών παιδικής πορνογραφίας, της Apple δεν πρόκειται να πέσει σε κυβερνητικά χέρια. Αυτό, τουλάχιστον, διαβεβαιώνει η εταιρεία, ακόμα και εάν της ζητηθεί έντονα κάτι τέτοιο.

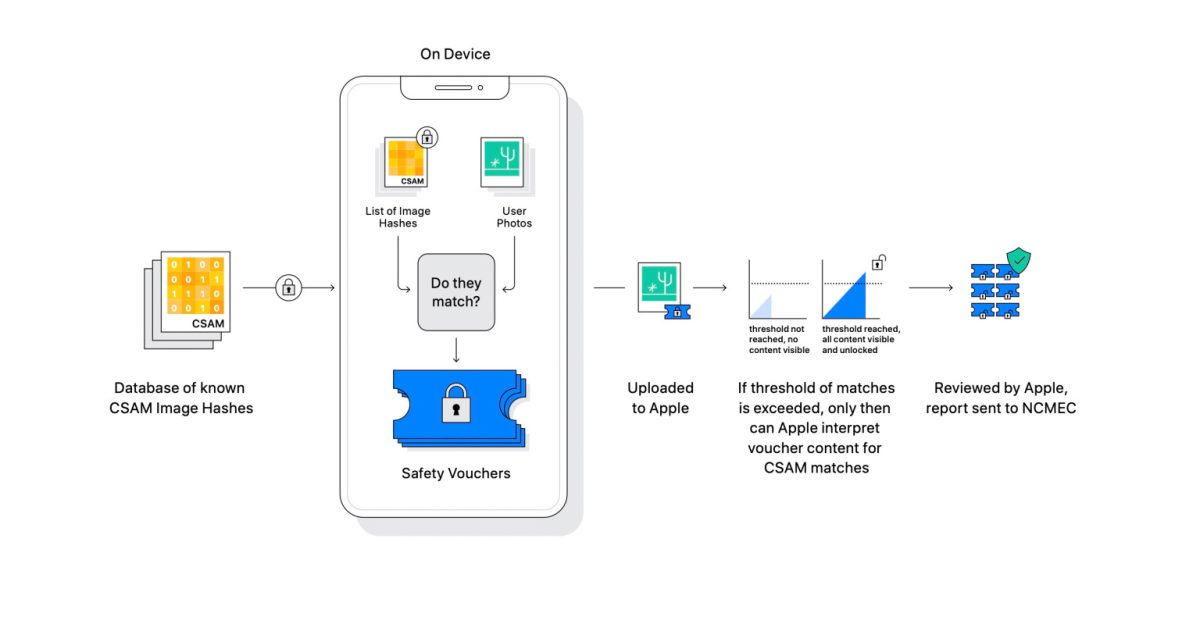

Το σύστημα CSAM της Apple αναλαμβάνει τον έλεγχο του iCloud για υλικό παιδικής πορνογραφίας ή άλλες περιπτώσεις παιδικής κακοποίησης, προκειμένου να εντοπίσει τέτοιο υλικό στους servers της. Όταν η Apple ανακοίνωσε ότι θα ξεκινήσει τον έλεγχο των δεδομένων που ανεβαίνουν στο cloud της, δημιουργήθηκε η εύλογη ανησυχία αναφορικά με το εάν έτσι δημιουργείται ένα εργαλείο μαζικής παρακολούθησης των πολιτών.

Για να διασκεδάσει τις ανησυχίες αυτές, η Apple ξεκαθάρισε ότι σε καμία περίπτωση δεν θα επιτρέψει τη χρήση της τεχνολογίας της από κυβερνητικούς φορείς και κρατικές υπηρεσίες, ακόμα και εάν της ζητηθεί επιτακτικά. Μάλιστα, η Apple διευκρινίζει ότι η συγκεκριμένη τεχνολογία είναι αυστηρά περιορισμένη στη χρήση στο iCloud και δεν πρόκειται να επεκταθεί για κανένα λόγο.

Αρχικά, η Apple θα εξετάσει τις φωτογραφίες που έχουν ήδη ανέβει στο iCloud και δεν πρόκειται να μπει σε ιδιωτικές συλλογές φωτογραφιών που δεν έχουν δημοσιευτεί σε online φακέλους.